소프트맥스 회귀 기법

소프트맥스 회귀는 n개의 레이블을 분류하기 위한 가장 기본적인 모델이다.

모델의 아웃풋에 Softmax함수를 적용해서 모델의 출력값이 각각의 레이블에 대한 확신의 정도를 출력하도록 만들어주는 기법이다.

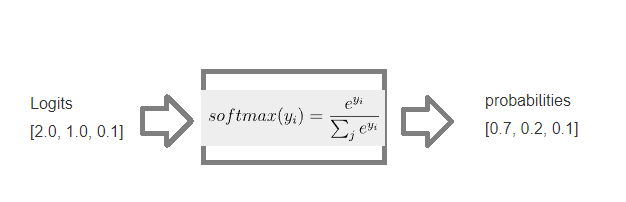

구체적으로 SoftMax함수는 Normalization함수로써 출력값들의 합을 1로 만들어준다. Softmax함수는 아래 수식으로 표현된다.

softmax(X)i=exp(xi)∑jexp(xj)

SoftMax함수를 마지막에 씌우게 되면 모델의 출력값이 레이블에 대한 확률을 나타나게 된다.

(출력값들의 합이 1이되므로)

예를들어 SoftMax함수를 적용하게 되면,

인풋에 대하여 각각의 레이블 확률을 0.7 , 0.2, 0.1 로 확신하게 해석할 수 있다.

개와 고양이 말을 분류하는 분류기를 만들었다고 가정해보면, 인풋으로 들어온 Logits에 대해, 소프트맥스 회귀를 통과하게 되면, 인풋으로 들어온 이미지가 70% 확률로 개, 20%확률로 고양이 10%롹률로 말이라고 판단하도록 확인할 수 있다.

'알고리즘' 카테고리의 다른 글

| 인공신경망(Artificial Neural Networks[ANN]) (1) | 2024.06.15 |

|---|---|

| TensorFlow2.0으로 MNIST 숫자분류기 구현 (1) | 2024.06.14 |

| One-hot Encoding (0) | 2024.06.13 |

| MNIST 데이터셋 (1) | 2024.06.13 |

| 크로스 엔트로피(Cross-Entropy) (0) | 2024.06.13 |